开源大模型Llama3本地部署 简单的方法: 支持CPU /GPU运行

发布时间:2024-04-22

目前在开源大模型领域,Llama3 无疑是最强的!这次Meta不仅免费公布了 8B和70B两个性能强悍的大模型,400B也即将发布,这是可以和GPT-4对打的存在!今天我们就来介绍3各本地部署方法,简单易懂,非常适合新手!

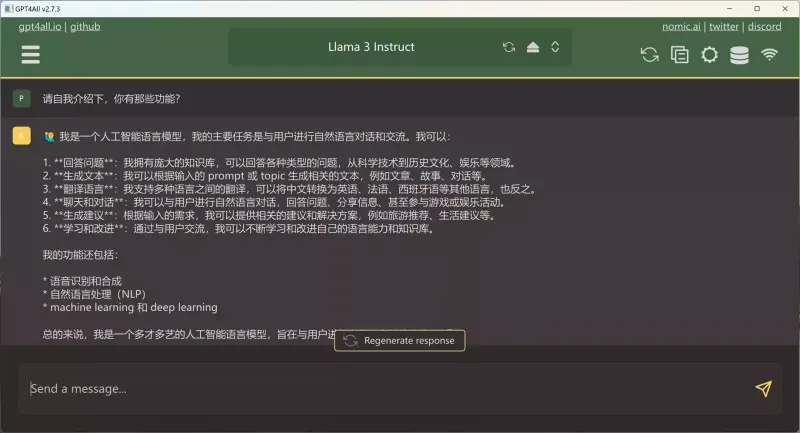

1. GPT4All : 适合低配置用户,可以在CPU/GPU上跑 【点击下载】

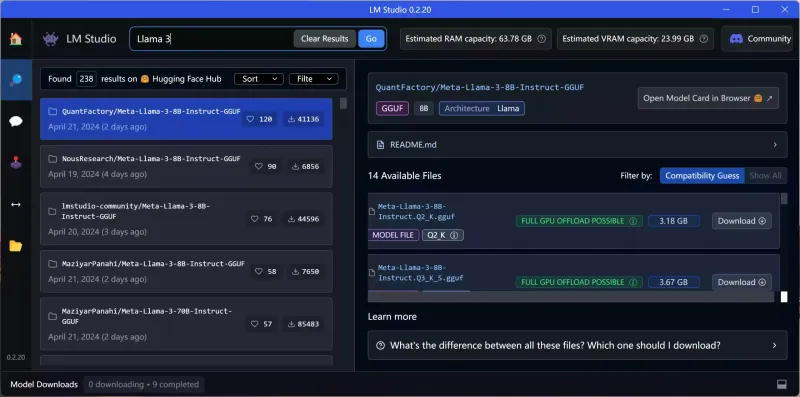

2.LMstudio ,支持下载多模型 8B/70B 等,模型选择更多!【点击下载】

3.Ollama,支持多平台!Windows / Mac /Linux 都可以运行 【点击下载】

并在 Windows 上打开 WSL 功能:

安装Docker Desktop :【点击前往】

然后本地安装webUI

(1)在CPU下运行:

(2)支持GPU运行:

安装完成通过本地地址:http://127.0.0.1:3000 进行访问