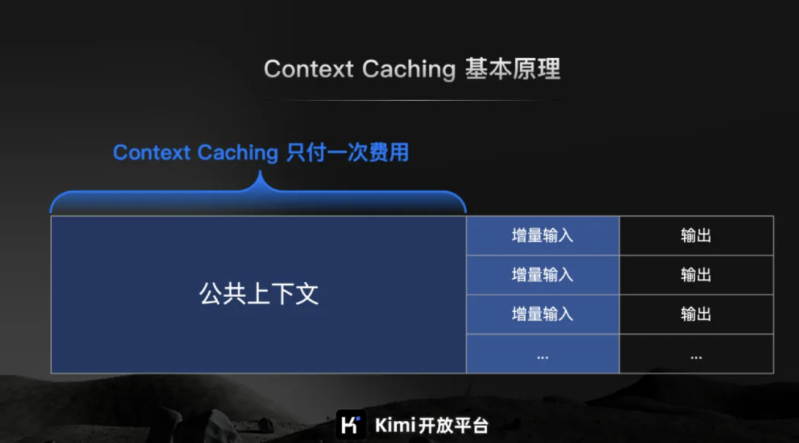

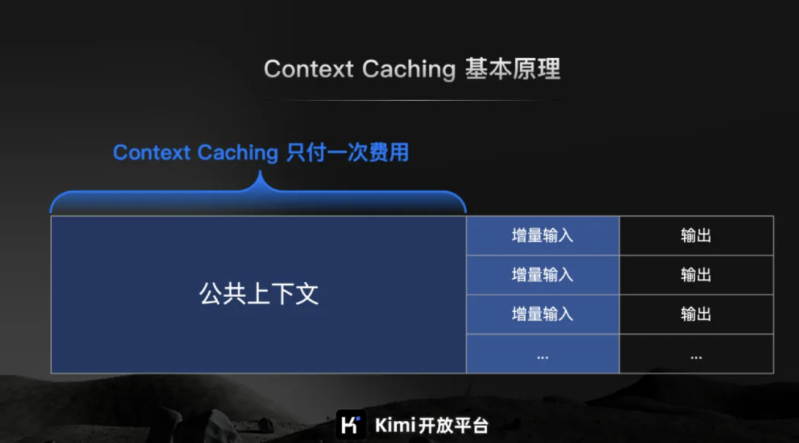

Kimi 发布Context Caching(上下文缓存)功能

发布时间:2024-06-20

-

提供大量预设内容的 QA Bot,例如 Kimi API 小助手。 -

针对固定的文档集合的频繁查询,例如上市公司信息披露问答工具。 -

对静态代码库或知识库的周期性分析,例如各类 Copilot Agent。 -

瞬时流量巨大的爆款 AI 应用,例如哄哄模拟器,LLM Riddles。 -

交互规则复杂的 Agent 类应用,例如什么值得买 Kimi+ 等。

提供服务器配置与维护、网站程序安装、网站程序定制修改等服务。根据问题难易程度定价,最低收费100元。